大数据文摘出品

来源:venturebeat

谷歌和纽约大学的研究人员在2014年就进行过一项研究,证明了物体和面部检测算法容易受到对抗性攻击,在研究中,识别模型可以被附加在目标上的一些特殊图案所欺骗。

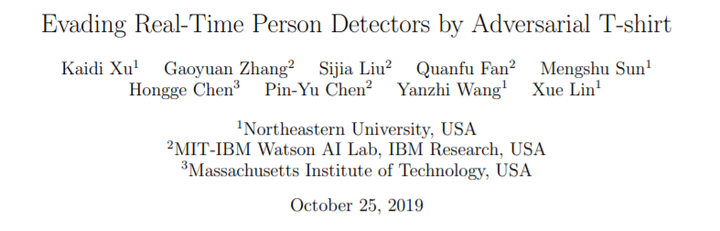

大多数对抗性攻击的研究涉及到像玻璃框架、停车标志或硬纸板这样的坚硬物体。但是西北大学和MIT-IBM Watson AI实验室的研究人员提出了一种他们称之为“对抗式”的T恤,尽管这种印有图案的T恤会随着人体姿势的改变而变形,但也能很好的避开人体探测器。

他们声称,针对流行的YOLOv2模型,它在对抗识别的成功率分别达到了79%和63% 。

今年年初,KU Leuven大学的工程师们也进行了一项类似的研究,他们展示了如何利用打印的图案来愚弄人工智能,同时,该大学的团队也声称他们的技术可以设计成这样一件对抗人体识别的T恤。

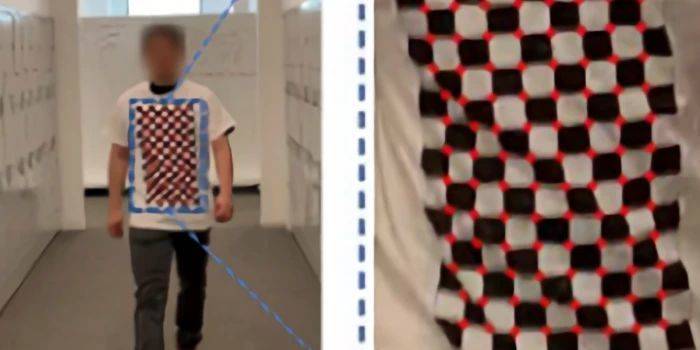

研究人员从研究中发现,一些对抗性的转换(transformations)常用于欺骗分类器,包括缩放、平移、旋转、亮度、噪音和饱和度调整。但是他们说,这些很大程度上不足以模拟由人体姿势变化引起的变形。因此,他们采用了一种称为薄板样条(TPS)的数据插值和平滑技术,该技术利用仿射(保留点、直线、平面)和非仿射分量来建立坐标变换模型,为非刚体对象提供一种学习对抗模型的方法。

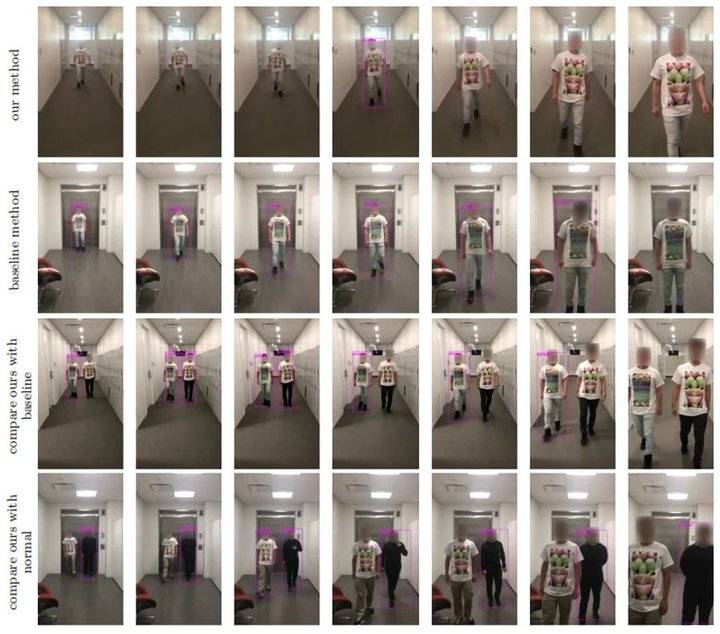

研究团队收集了两个数据集,并进行了一系列实验,让模型在物理和数字世界中学习和测试他们的攻击算法。两个训练数据集中包含了三类视频,第一类是在数字环境中,穿着对抗性T恤的虚拟移动人物在30个不同场景中拍摄的30个视频;第二类包含在相同环境中使用不同虚拟人物拍摄的10个视频;第三类是一个真实世界的数据集,包括10个测试视频,视频中有一个人穿着一件对抗性T恤在运动。

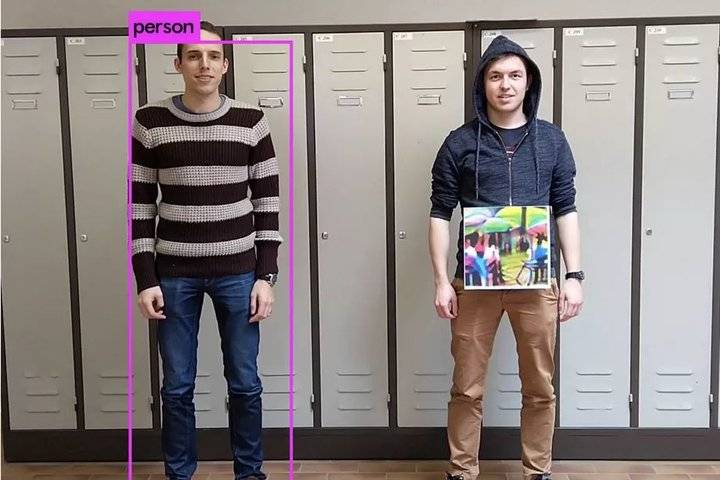

模拟测试中,研究人员在对抗R-CNN模型和YOLOv2模型的人体检测中,分别获得了65%和79%的攻击成功率。在现实测试中,对抗性t恤骗过两种模型的几率都是65% ——至少在单人对抗情况下,如果有两个或两个以上的人,成功率就会下降。

但是,这种方法很可能骗不了像亚马逊网络服务、谷歌云平台和微软 Azure 这样更复杂的对象和人员检测模型。虽然65%的成功率说起来也只比随机成功稍好一点。但研究人员认为,他们的工作是迈向可以躲避移动人员检测的对抗性可穿戴设备的第一步。

论文的合著者写道:“由于T恤衫是非刚性物体,因此在产生对抗性干扰时,应该考虑到运动人体姿态变化所引起的变形。基于我们的研究,我们希望通过人体服装、配饰、脸部涂料和其他可穿戴设备为这种对抗干扰提供一些启发。”

找记者、求报道、求帮助,各大应用市场下载“齐鲁壹点”APP或搜索微信小程序“壹点情报站”,全省600多位主流媒体记者在线等你来报料! 我要报料

推荐阅读:旗龙

(正文已结束)

设为首页

设为首页 加入收藏

加入收藏 手机

手机